Vol.119-2

本連載では、ジャーナリスト・西田宗千佳氏がデジタル業界の最新動向をレポートする。今回のテーマは、キーワードを入れるだけで高精細なイラストが描けるAIサービス。代表的なサービスといえるMidjourneyやStable Diffusionができた経緯をさかのぼる。

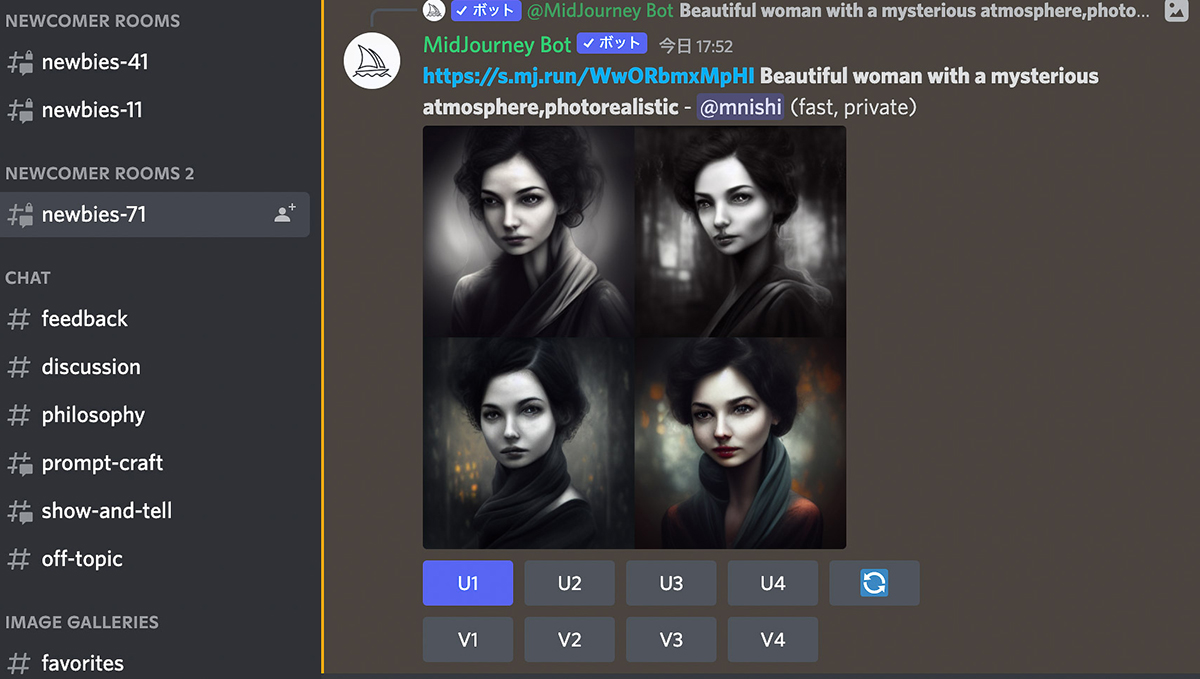

MidjourneyやStable Diffusionのような「絵を描くAI」は、今年の夏になって急速に盛り上がった。ただ、その経緯は技術によって異なる部分がある。

言語などから内容を解釈し、絵や文章などのアウトプットを得る技術は以前から存在した。ひとつの転機となったのは、AIを研究する非営利団体「Open AI」が2021年1月に公開した「DALL-E」だ。DALL-Eは、同じくOpen AIが2020年5月に開発した言語処理AI「GPT-3(Generative Pretrained Transformer 3)」をベースにしている。

GPT-3は言語処理の分野で劇的な成果をもたらしたAIだ。日本では言語の差もあり、技術コミュニティ以外ではそこまで話題にならなかった印象があるが、少なくとも英語においては、かなり人間に近い文書を作り出すことが可能。「ある種の壁を越えたのでは」と、当時大きな話題になった。

言語の解釈からある結果を導き出し、そこからさらに絵を描く、というアプローチはこのときかなりハイクオリティなレベルに達していた、と言って良い。

そこに出てきたのがMidjourneyだ。Midjourney自体は独立した企業が開発したソフトウェアだが、そのアプローチがDALL-Eの影響下にあるのは間違いない。Midjourney開発元のCEOであるデヴィッド・ホルツ氏は、アメリカでいくつかのメディアへのインタビューに答え、「開発は1年半ほど前からスタートした」としている。時期的には、DALL-Eが公開された時期と重なるので、アイデアや方向性の面で大きな影響を受けているのは間違いなさそうだ。

というのは、DALL-Eはそのアプローチなどは公開されているが、ソースコードやAIの学習モデル自体が公開されているわけではない。だから、DALL-Eを元になにかを開発することはできないのである。そのためMidjourneyも、影響は受けているが、あくまで独立したソフトウェアとして開発されたものだ。Midjourneyは月額料金制の有料サービスであり、Midjourney自身のソースコードや学習モデルも公開されていない。

一方で、Stable Diffusionは違う。Stable Diffusionを開発したのは「Stability AI」という企業だが、開発はオープンコミュニティで行なわれた。Stability AIの創業者であるエマード・モスターク氏は、「Stable DiffusionはAIの民主化のためのツールだ」と答えている。そのため、ソースコードや学習モデルも公開されているし、巨大なクラウドサーバーではなく、個人のPCでも動かせるようにもなっている。とはいえ現状、高性能なGPUは必須なので、どんなPCでもOK、というわけではない。

ソースコードなどがオープンになっていることで、Stable Diffusionを元にした別のAIを開発することも容易になっている。結果として、派生AIやユーザーインターフェースを変えたものなど、まさに多数の「お絵描きAI」が広がることになった。MidjourneyもStable Diffusion公開後、さらに質を上げたバージョンを公開している。

こうした変化が、今年7月からのたった3か月ほどで一気に起きたことがなによりも驚きであり、もはや時代が後戻りしないことを示している。

では、「お絵描きAI」はどのような影響を我々にもたらすのか? そうした部分は次回以降、考察していく。

週刊GetNavi、バックナンバーはこちら