GoogleはAI(人工知能)を使って、テキストから画像を生成するシステム「Imagen」を発表しました。その概要とともに、実際に「AIがテキストを元にして描いた」という数々の画像も公開されています。

こうした「好きなテキストを入力すると、それに一致する画像を描く」AIシステムの開発は盛んになっており、これまで米AI研究所OpenAIによる「DALL・E2」が最先端を走っていましたが、Googleは競合他社よりも出力が優れているとアピールしています。

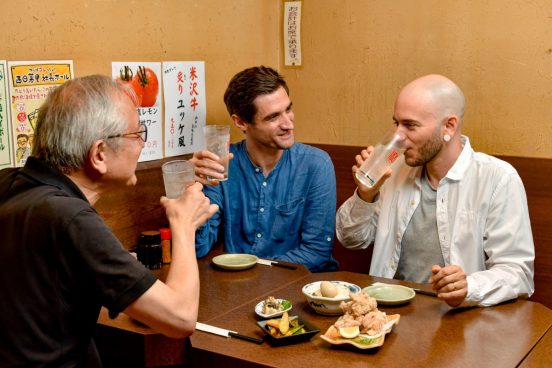

このImagenが描いたという画像は、たとえば「自転車に乗ってバックパックを背負った柴犬の写真。サングラスとビーチハットを被っている」というものや「寿司ハウスで暮らしている可愛いコーギー犬」から「ロケットに乗った脳みそ、月に向かう」など夢に満ちたものもあり。おおむね「こう描いて欲しい」という願いに沿っているとも思われます。

しかし、テックメディアThe Vergeは、Google Brainのような研究チームが新たなAIモデルを発表するときはベストの結果だけを選び出す傾向があると指摘しています。これらの画像が完璧で洗練されているように見えてはいるが、平均的なデキがこの水準だとは限らないというわけです。

一般に「Text-to-Image」(テキストから画像を生成)プログラムで作られた画像は未完成だったり不鮮明だったり、ぼやけた感じになることがよくあります。これは上記の「DALL-E」プログラムでも度々あったことで、その不出来な方が明かされていないことが逆に怪しまれているしだいです。

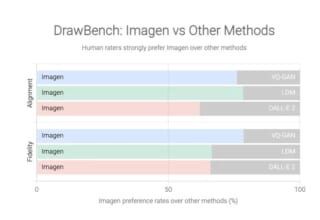

しかし、Googleは本プロジェクト用に作った新たなベンチマーク「DrawBench」に基づいて、自社のmagenがDALL-E 2よりも常に優れた画像を作れると主張しています。このDrawBenchは基本的には約200のテキストを入力した上で、各AIにつき人間レビュアーが判定するもの。それによりImagenの出力はライバルよりも人間に好まれる結果が出た、とされています。

ただし、GoogleはImagenを「現時点では一般利用に適さない」として、外部ユーザーの利用を許可していません。なぜなら「明るい肌色の人々の画像を生成する全体的な偏りや、異なる職業を描写する画像が西洋のジェンダーステレオタイプに一致する傾向など、いくつかの社会的偏見や固定観念をコード化している」ことを懸念しているため。要するに人間といえば白人に偏るなど、人種差別を助長してしまう恐れがある、というわけです。

Googleは「今後の作業における社会的・文化的バイアス」を測る新たなベンチマークを作り、将来くりかえしテストする予定だと述べています。そうしたステレオタイプな偏見が、知らず知らずに組み込まれてしまう……という危険はすべてのAIにありますが、Googleといえども克服には苦労するかもしれません。

Source:Google

via:The Verge