4日間の会期中に20万人近くが会場を訪れる世界最大のIT家電ショー「CES2019」。会場を訪れて驚くのがクルマ関連の出展が極めて多いことです。CESにおけるクルマ関連の出展といえば、かつてはカーオーディオが中心でした。それが7~8年ほど前、電気自動車(EV)がCESに出展された頃から様相が変わってきました。自動車メーカーがこぞって出展するようになり、それに伴って自動車部品メーカーまでもが軒を連ねるようになったのです。

そして、今年はその流れに新たな動きが加わりました。ここからは会場で見つけた、未来を感じさせる驚きの技術として、「空飛ぶタクシー」「自動運転レベル4」「視線入力を組み合わせた音声認識」のを3つをご紹介しましょう。

【その1】

実現はもうすぐか?「空飛ぶタクシー」

自動車メーカーが軒を連ねるノースホールを歩いていると、何やらドローンのお化けみたいなものが目に飛び込んできました。これは日本では米軍が配備しているオスプレイを開発したことで知られるベルヘリコプター社(以下ベル)が「空飛ぶタクシー」を想定して開発を進めている「ベル ネクサス」です。

これまで「都市交通」といえば、陸の移動に限られていました。これはいわば“2次元での移動”です。それが数年前から、空を活用する“移動の3D化”を目指す動きが活発化し始めました。空を使えば地上のような渋滞はなくなり、高速で目的地へ移動できます。まさに「ベル ネクサス」はその発想で開発が進められているのです。

定員はパイロットも含め5名。航続距離は150マイル(約241km)、最高速度も150マイル(約241km/h)。将来は自動運転も視野に入れているといいます。そうなれば、まるまる5人が乗客として乗り込めるようになりますね。

この話、決して夢物語ではありません。ベルは昨年、2023年にも「空飛ぶタクシー」の実現を目指しているウーバー・テクノロジーズとパートナー契約を締結しました。つまり、ベルは本気で「ネクサス」の実用化を目指して開発に挑んでいるのです。スマートフォンで予約すると空からタクシーが無人で舞い降りてくる!CES2019ではそんなタクシーの未来を予感させてくれたのでした。

【その2】

ラスベガスの街を自動運転「レベル4」で走った!

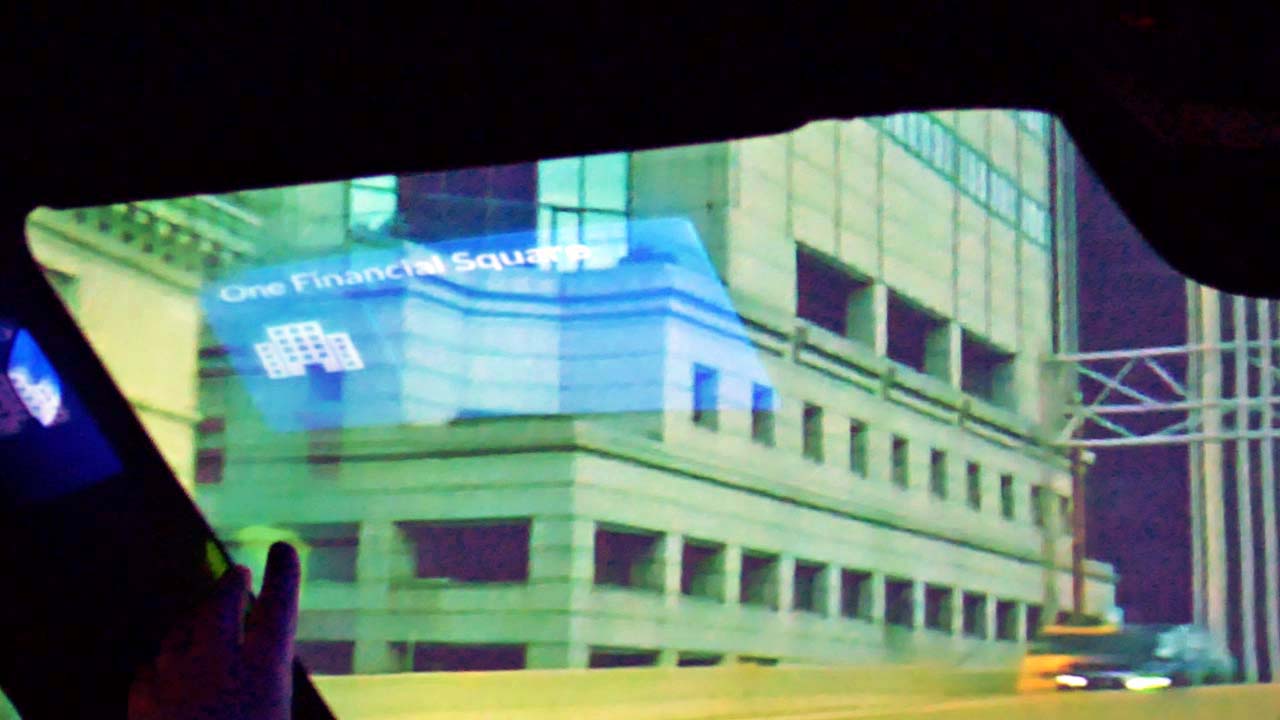

自動車関連で話題なのはやはり「自動運転」。今年もCESの定番のイベントとなりました。会期中に自動運転のデモを公道で行うのは今や恒例行事となり、年々その認識力やスムーズさが向上。その成果を来場者に披露しています。今回はフランスの自動車部品サプライヤー「ヴァレオ」のデモを体験してきました。実際の体験の様子は、以下の動画でもご覧ください。

ヴァレオ社が用意したのはヴァレオのカラーリングが施された「レンジローバー・イヴォーク」。ここに自動運転には欠かせないセンサーとして、LiDARやカメラなどを組み合わせた自動運転「レベル4」のシステム「Drive4U」が搭載されていました。

センターパネルにある大型のディスプレイには自動運転に必要な情報として、あらかじめ登録された高精度地図とリアルタイムでセンサーが取得した情報が表示されます。その情報のもと、信号や車線、周囲の車両などを認識しながら自動走行するのです。

ドライバーが運転席と助手席の間にあるつまみを引き上げて右へ回すと自動運転の開始です。それ以降はすべて自動で走行するようになり、赤信号で確実に停止するのはもちろん、発進も自動。先行車との車間もきちんと取り、ブレーキも熟練ドライバーのようにスーッとかけていきます。同乗していても、自動運転していることには全く気づきません。

驚いたのは、路地からクルマが出てきた際の対応。クルマの動きを予測して判断し、必要であれば自車を自動停止させたのです。これは人間に対しても同じ動きを示すそうです。さすがに交差点での左折(日本の右折に相当)は信号で矢印が出る場所を選んでルートを設定していましたが、最後まで動きはスムーズそのものでした。自動運転は着実に実現へ向けてその形を見せ始めているといっていいでしょう。

【その3】

「視線入力」を組み合わせた音声認識で未来を体感!

CES2019では進化した音声コントロールの実例を見ることができました。それを披露したのが、音声認識エンジンの世界的プロバイダーとして知られるニュアンス・コミュニケーション(以下:ニュアンス)で、開発中の自動車用音声認識エンジン「ドラゴン・ドライブ」の最新バージョンを披露したのです。実際に体験した様子は、以下の動画でもご覧いただけます。

同社は「Hi,Mercedes!」をキーワードに立ち上げる音声認識を開発したことでも知られていますが、今回のデモはいわばその発展系で、音声認識入力に加えて視線入力を追加しているのが最大のポイントとなります(動画の36秒あたり~、2分15秒~)。そのために、フロントウインドウにタイル状のメニューを表示するプロジェクターが準備され、ドライバーの視線を読み取るためとして赤外線カメラが設置されていました。

デモがスタートしてまず驚かされたのが、目で見た方向のドアに向かって「Open the Door(ドアを開けて)」と発話するだけで対象のドアが開いたのです(動画の36秒あたり~)。今までの音声認識なら「Open the right door(右のドアを開けて)」と細かく指定する必要がありましたが、このシステムでは開けたいドアを見ながらコマンドを送ればいいのです。これは窓を開けるときなどでも有効なのはいうまでもありません。

さらに驚かされたのは、フロントウインドウに映し出されたタイル状のメニューも視線入力できていたことです(動画の2分15秒あたり~)。電話をかけるときはそのリストに視線を合わせて「This One(こここにかける)」と発話するだけ。また、外側の風景との連動も実現しており、なんと対象の建物を見ながら「What is a building(この建物は何ですか?)」と発話すれば答えが出てくるのです。その様子は本当にガイドが横に座って答えてくれているかのようでした。

例年CESへ出掛けると“未来”を実感して帰国するのですが、今年は実現可能な近未来がより鮮明に提示されていたような気がします。子どもの頃に夢描いていた“21世紀”がようやく現実のモノとなる日が近づいてきている――。そんな感想を抱いたCES2019でした。