Vol.151-1

本連載では、ジャーナリスト・西田宗千佳氏がデジタル業界の最新動向をレポートする。今回はGoogleが公開したAIを活用したスマートグラス「Android XR」の話題。これまでのスマートグラスと異なる点と新たな可能性を探る。

今月の注目アイテム

AI活用型スマートグラス

価格未定

スマートグラスが新たなフェーズに入る

Googleは5月に開催した開発者会議「Google I/O」にて、新しいプラットフォームである「Android XR」をお披露目した。昨年12月に開発者に対して情報公開をしていたものが、今回はより一般向けの情報公開となった。

Android XRは、Androidを核としてXR(仮想現実・拡張現実など)を体験するプラットフォームだ。

第1弾の製品となるのは、Apple Vision Proの対抗とも言われるサムスン製の「Project Moohan(プロジェクト・ムーハン)」で、海外では年末までに発売される。日本では未定。価格やスペックなどの詳細も未公開だ。

ただし、Google I/Oで大きな話題を呼んだのはProject Moohanではない。初めて一般公開された、「AI活用型スマートグラス」のプロトタイプだ。外観は一般的なメガネのようにしか見えない。だが内部にはカメラとマイク、スピーカー、それにディスプレイ(右目にのみ表示)が内蔵されており、スマホと連動して動く。

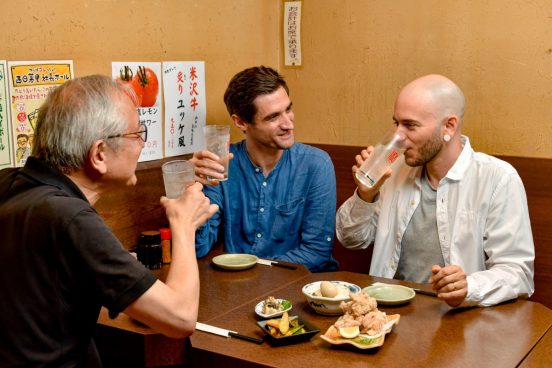

スマートグラスでできることは多彩だ。カメラを使って目の前のものが何かを認識したり、メニューや看板を翻訳したりもできる。Google Mapを使ってナビゲーションも表示できる。そして基調講演では、スマートグラスをかけた人同士での会話をリアルタイムで翻訳するデモも行われた。

同じAndroid XRを使っているものの、両者の体験は大きく異なる。Project Moohanは、リッチなビジュアルによる没入体験やPCなどの巨大な画面を表示して作業環境を整えるものだ。それに対してスマートグラスは、街中でスマホやAIからの情報を生かすためのもの、といっていい。

自分に見えるものから情報を引き出す

スマートグラスというとAR(拡張現実)、と考える人も多いだろう。しかしAndroid XRのスマートグラスは、情報は表示されるがARではない。情報は表示するが、現実の場所にCGが固定され、現実にある風景がCGで“拡張”されるわけではない。だが、その場所で必要な情報を活用できるだけでも価値は大きい。

例えばGoogle Mapのナビの場合、正面を向いていると次にどちらへ曲がるかの「ターン・バイ・ターン」ナビを表示する。だが、立ち止まって下を見るとそこには、スマホでお馴染みのマップ全体図が見える。スマホを持ったりスマートウォッチに目を落としたりすることなく、自然にナビを体験できる。

もちろん、スマホからの通知を確認したり、声で返答したりもできる。看板に書かれた他国の文字を自国語に変換したりもできる。どれもスマホでできることではあるが、それを自分の視界に置き換え、さらに「自分に見えるもの」から情報を取り出す……という流れになる。

AIの力を使い、周囲の状況を把握することは十分可能になってきた。Googleは同社のAIである「Gemini」を活用、差別化するものとしてスマートグラスを使う。ではその計画はなぜ生まれたのか? XRの名前を冠する理由はなぜなのか。そこは次回以降で解説していく。

週刊GetNavi、バックナンバーはこちら