Metaはスマートグラスの「Ray-Ban Meta」にライブAIやライブ翻訳などの新機能を追加したと発表しました。前者は内蔵カメラが捉えた映像をAIが分析して情報を表示し、後者はリアルタイムで異なる言語を話す人と会話できます。

公式リリースによると、この新機能はハンズフリーで食事の準備や庭いじり、初めての場所の探索など、さまざまな場面で役に立つとのこと。

ユーザーは「ヘイ、メタ」というウェイクワード(AIを起動する言葉)を前置きせずに質問できる一方、AIは会話の文脈も理解できるそうです。最終的にはAIから「質問する前に役立つ提案ができる」ようになるとも述べています。

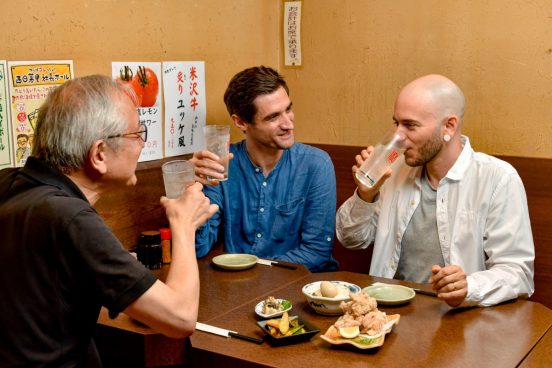

ライブ翻訳機能は、英語とスペイン語、フランス語、イタリア語の間でリアルタイムに翻訳できるというもの。これら3つの言語(英語以外)のどれかが話されると、メガネは内蔵スピーカーから音声、または接続したスマホの画面に文字を表示することで英語に翻訳。その逆もできるそうです。

さらに、街角で流れている音楽をShazamアプリを使って特定できるとのこと。「ヘイメタ、この曲は何?」と尋ねると、曲名を教えてくれると言います。

これらの機能は、Ray-Ban Metaグラスのユーザーであれば、誰でも参加できるアーリーアクセスプログラムの一環です(本製品は今のところ日本では販売していません)。

その一方、アップルもMetaのようなスマートグラスを開発中と噂されています。Meta製品に対する競争力を上げるため、アップルも同じようなAI機能を実装すると期待したいところです。