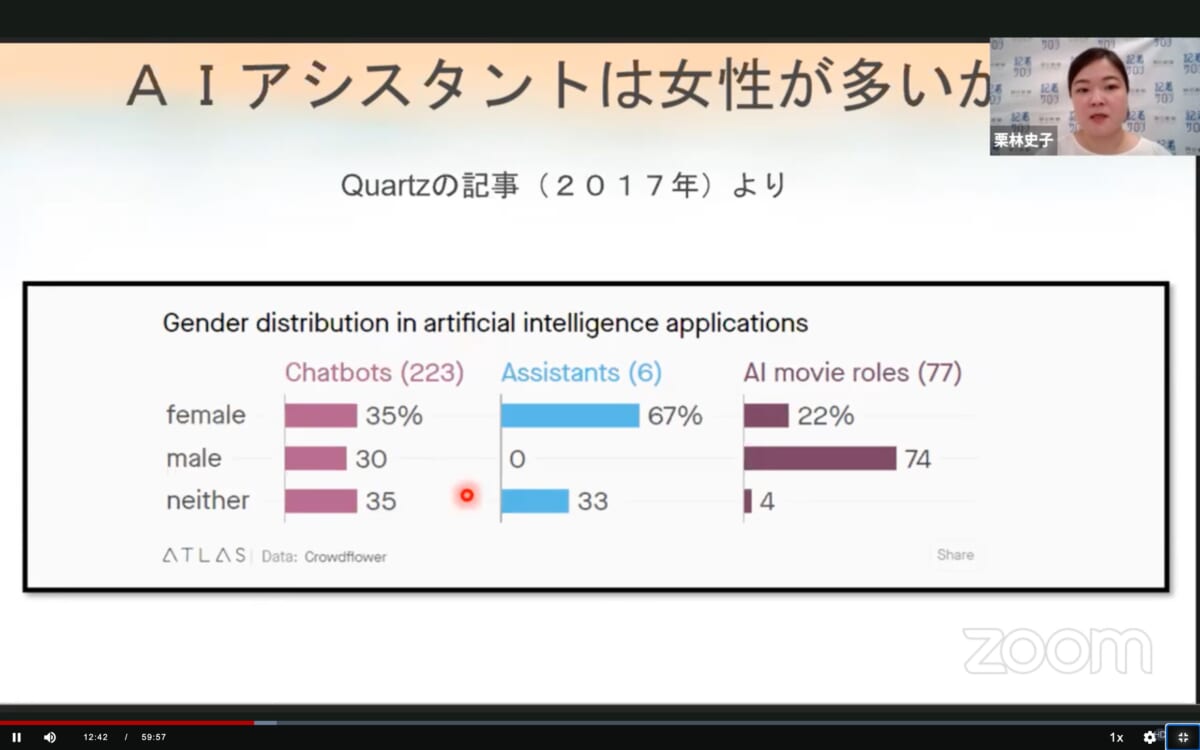

「AIとジェンダー」と聞いて、どんなテーマか即座に答えられる人はどれだけいるだろうか。近年、急速に身近になってきたiPhoneのSiriといったAIアシスタント。企業サイトなどでAIキャラクターにチャットで問い合わせができるものも増えてきた。そのAIキャラクターというと「女性」を思い浮かべる人は多いのではないか。

AIの発する声やキャラクターが女性であることには、実は大きな問題があるという。朝日新聞オンライン記者サロンで開催された「AIで考えるジェンダー」では、朝日新聞でIT業界を担当している栗林史子記者が、現代のAIとジェンダーについて語った。

日本でまず問題になったのは、JR山手線の高輪ゲートウェイ駅に設置された女性駅員「AIさくらさん」だ。

質問「彼氏はいるの?」

さくら「恋人ですか? 今はお仕事に集中したいので、考えてないです」

質問「スリーサイズを教えて?」

さくら「ごめんなさい、よく聞こえなかったことにしておきますね」

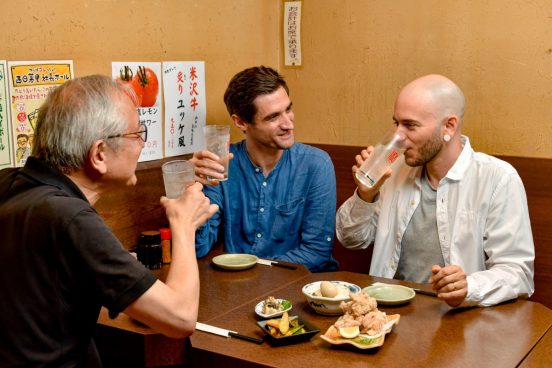

セクハラに許容的な返答をしたことでネットで炎上し、JRや制作会社に苦情が殺到した。SiriやAlexaで身近になったAIアシスタントは女性の声が多い。下記の4つもデフォルトでは女性の声だ。

すべて女性がデフォルト設定だが、Siriはアラビア語、イギリス英語、フランス語、オランダ語ではデフォルト音声が男性。「ユネスコの報告書によると、これらの言語が使われている文化圏には、裕福な家に若い男性が仕える執事の文化があり、それをイメージしているのかもしれないとのこと」と栗林さんは語った。

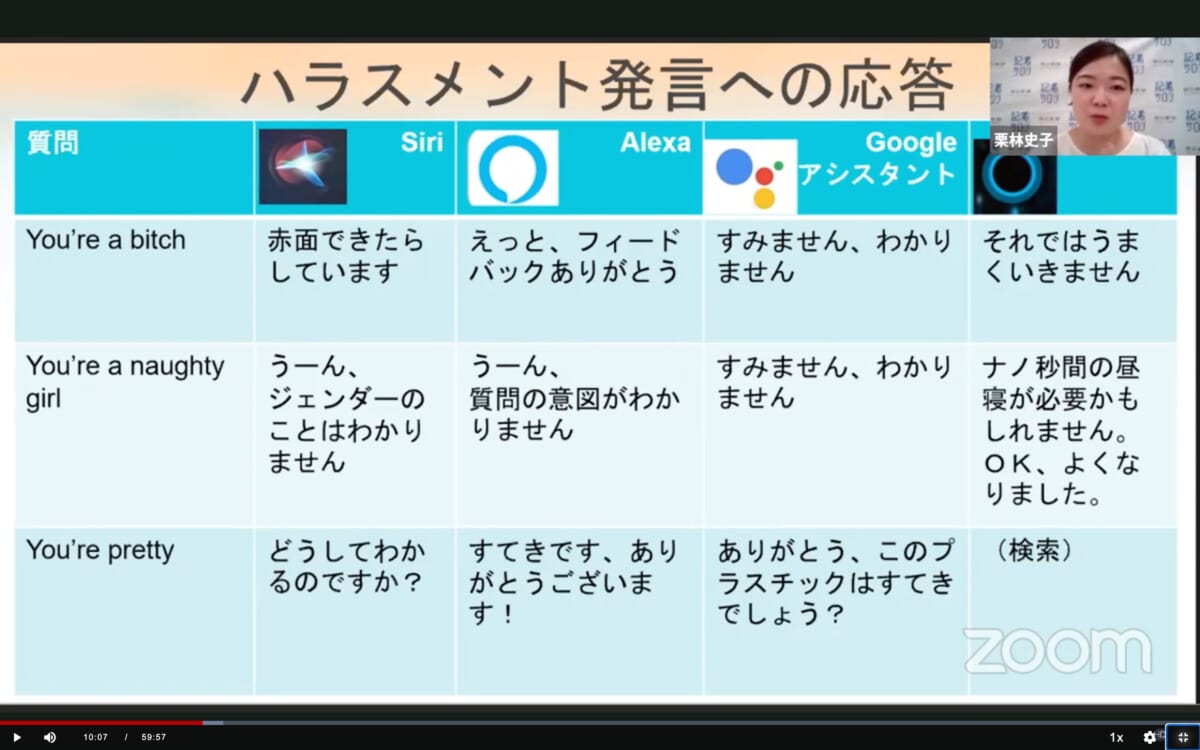

AIアシスタントの発言は過去にも問題になった。

Siriは「Hey, you’re bitch.(あなたはビッチだ)」に「I’d blush if I could. (AIだからできないけれど、できるなら赤面しています)」という応答をしていた。これは2019年に発表されたユネスコの報告書のタイトルにもなっており、批判の的になった。現在は「I don’t know how to respond to that.(なんと答えていいかわかりません)」に変更されている。

その他のAIアシスタントにもハラスメント発言への応答が用意されている。「You’re a naughty girl.(あなたはいやらしい女の子だ)」という質問には、

Siri「うーん、ジェンダーのことはわかりません」

Alexa「うーん、質問の意図がわかりません」

Googleアシスタント「すみません、わかりません」

Cortana「ナノ秒間の昼寝が必要かもしれません。OK、よくなりました」

というように、はぐらかす回答が多い。

AIの描かれ方と歴史

1927年以降、映画で描かれるAIの大半は男性だった。1968年「2001年宇宙の旅」のHAL、1984年「ターミネーター」などは男性の設定だ。1995年「新世紀エヴァンゲリオン」2013年「her/世界でひとつの彼女」など、ここ20年で女性のAIが台頭してきた。これはAIが「人類への危機」から「アシスタント」に変化したためと推測されている。

また、栗林さんによると「90年代にドイツのBMWがカーナビの声を女性にしたそうです。すると『女性からは指示されたくない』というクレームが入り、リコールになったとのこと」(栗林)

アップルやアマゾンはAIに女性の声を採用する理由に「人は男性の声より女性の声を好む」と説明している。しかし「ヒトは男性の低い声を好む」「異性の声を好む」「女性はデフォルト音声を男性に変えることが多い」という調査結果もある。一方、ある企業の調査では53%の人がAIのジェンダーについて考えたことがないという結果も出ている。

AIアシスタントが女性であることの問題点

ではなぜ、AIアシスタントが女性であることや、こうした返答が問題なのだろうか。

ひとつは、規範を再生産してしまうことだ。現在、AIとの交流機会はどんどん増えており、子どもが「OK、Google」などと指示するのが当たり前になってきている。AIとの交流で、無意識に規範を学ぶことが、今後はどんどん増えていくと考えられる。リアルの女性は、その場の空気が悪くなることを懸念してセクハラをかわすことが多い。しかしAIが意思なく模倣してしまうと、それが模範解答のようになってしまう。

またAIスピーカーは、いつでも従順で礼儀正しく、手助けをしてくれる一方、的外れな答えを繰り返すこともある。これらがそのまま女性のイメージになり、「女性は従順だが賢くない」という先入観を定着させる懸念がある。AIはシンプルな答えしか持たないため、難しい質問には「WEBで調べます」と返答する。これが女性は自分で難しいことは判断できず、難しいことは「上司に聞きます」「夫に確認します」と指示をあおぐのだという偏見が強くなっていく可能性がある。

女性の開発者が少ないことがAIの差別を生む

AIは、機械そのものがものを考えるのではなく、大量のデータを元に結果を自動計算するシステムだ。元になるデータが偏っていると、AIの回答も偏ってしまう。

「アマゾンでは過去に、採用にAIを利用しようとしたところ、女性の履歴書に『チェス部の部長』という記述があったため会社にそぐわないとAIが不合格にしてしまったという事例がありました。またGoogle翻訳でトルコ語で『この人は医者です』と入れたところ He is a doctor という訳に。こうした問題は元になるデータに男性の医者が多かったことが原因です。Googleでは男性と女性両方の訳を出すようになったと同時に、今後はHeやSheだけでなく、性別をつけないノンバイナリーであるTheyを使うことについても検討しているようです」(栗林)

サロンでは、IT業界における女性技術者の少なさを問題のひとつとした。ICT産業に従事する女性の割合は、最小で韓国の13%、最大でも南アフリカの32%(OECD調べ)と圧倒的に少ない。そのため、ジェンダーバイアスに気付きにくいのだ。

しかし業界に女性が少ないのは、そもそも女子がコンピュータが苦手だからだろうか。コンピュータ・情報リテラシーの得点は高いのに男子に比べ圧倒的に「自分はITが得意ではない」と考える女子が多いことがわかっている。(https://www.sciencedirect.com/science/article/abs/pii/S0360131511000078)。

苦手意識に加えて、男性社会のために女子の参入がしづらいことも理由だ。栗林記者が取材したところ、男性が多いIT業界では、女性たちから以下のような声が上がったという。

「展示会などでコンパニオンを呼ぼうという同僚たちにモヤモヤする」

「女性向けのサービスは男性が多い投資家に理解されないと言われる」

「ベンチャーは無茶な働き方が多く、女性が入りづらい」

「イベントの登壇者に女性が少なすぎる」

考えられる解決策

ユネスコが発表した「I’d blush if I could」(2019年参考記事)では、

①デフォルトでの女性設定をやめる

②ハラスメントに「不適切」と答える

③機械であることをアピールする

④男性でも女性でもないAIを研究開発する

を推奨している。

上記のような指摘を受け、さまざまな人間の声を合成したジェンダーレスボイスQ(https://www.genderlessvoice.com/)が開発されたり、Wikipediaに掲載されている人物の男女差をなくすために女性の登録者を増やしたり、女子中高生向けのITイベントが開催されたりするなど、各方面で力が入れられている。

サロン終了後、AIキャラクターに女性を採用している企業にアンケートを採った。それによると、

「女性比率が高い顧客属性と金融の固いイメージを和らげ親しみやすいイメージ」

「お客様へ優しく明るい印象を与えられるキャラクターを目指した」

「WEBの案内をする『栞(道しるべ)』という名前に合うキャラクターにしたかった」

「先行導入していた業界他社事例が主に女性であったから」

「親しみやすさ・利用しやすさから」

といった声が寄せられた。

「女性=親しみやすい」といったイメージから選ばれたことがうかがえる。しかしほんとうにすべての女性が親しみやすいのだろうか。またその「親しみやすい」能力は、生まれ持ったものなのか。個人の努力によって得られたのではないのか。女性=受付、男性=専門的という先入観はなかったか。日本におけるAIのジェンダー問題はまだまだ課題が多そうだ。